Moiré entsteht überwiegend aus Fehlern bei der Farbinterpolation von Sensoren mit Bayer-Muster und kann durch ein Tiefpassfilter verringert werden.

Die Auflösung einer Digitalkamera wird im Wesentlichen von der Abbildungsqualität des Objektivs und der Pixelzahl des Bildsensors bestimmt. Wenn das Objektiv an die Grenze seines Auflösungsvermögens gelangt, sinkt der Kontrast feiner Details so weit ab, bis sie nicht mehr erkennbar sind, und am Ende bleibt nur eine strukturlose Fläche. Das Verhalten eines CCD- oder CMOS-Bildsensors an seiner Auflösungsgrenze ist dagegen viel komplexer.

Abtasten

Der Sensor zerlegt das Bild in ein Raster von Zeilen und Spalten und misst die Helligkeit in jedem der Pixel, aus denen sich das digitale Bild zusammensetzt. Die Kamera kennt also nicht die Helligkeit an jedem beliebig kleinen Bildpunkt, sondern nur in einer festen Zahl kleiner Quadrate. Die Eigenschaften solcher Abtastverfahren und die Genauigkeit, mit der sich aus dem Resultat der Digitalisierung das analoge Original rekonstruieren lässt, werden mathematisch exakt durch das Abtasttheorem beschrieben. Dieses besagt, dass eine Schwingung an mehr als zwei Stellen abgetastet werden muss, damit sie aus den Messwerten wiederhergestellt werden kann. Das Musterbeispiel für eine Schwingung ist ein Linienpaar, also ein Wechsel zwischen Hell und Dunkel, und das Maß der (Orts-) Frequenz ist die Zahl der Linienpaare pro Millimeter. Die Aussage des Abtasttheorems ist in diesem Fall sogar besonders anschaulich: Um ein Linienpaar wiederzugeben sind mehr als zwei Reihen von Sensorpixeln nötig.

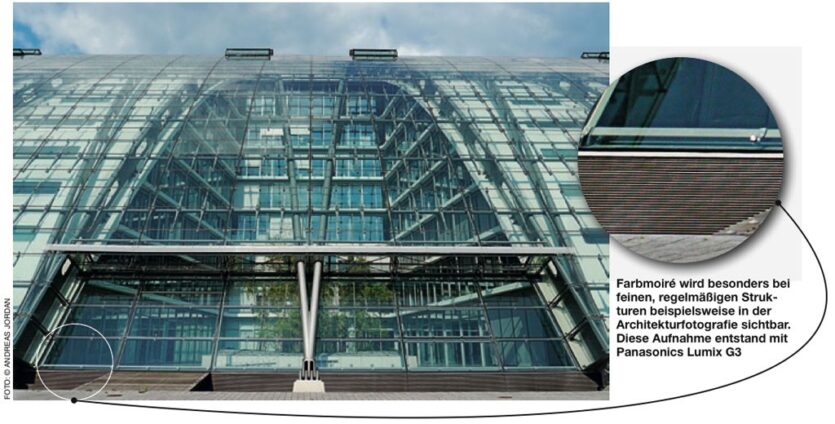

Farbmoiré wird besonders bei feinen, regelmäßigen Strukturen, beispielsweise in der Architekturfotografie sichtbar.

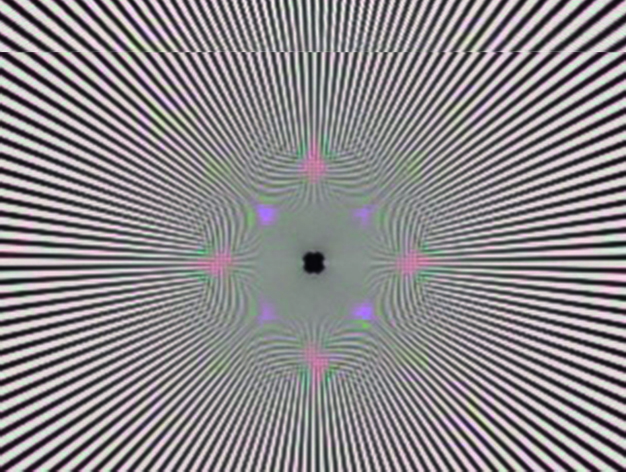

Foto: Michael J. HußmannMoiré

Auch Frequenzen oberhalb der halben Abtastrate werden noch digitalisiert, erzeugen aber störende Artefakte. In Digitalbildern erscheint statt feiner Details farbiges Moiré. Zur Vermeidung solcher Artefakte muss man die problematischen hohen Frequenzen schon vor der Digitalisierung mit einem Tiefpassfilter entfernen, das nur Schwingungen unterhalb der halben Abtastrate durchlässt.

Ein optisches Tiefpassfilter, wie es üblicherweise Teil der Sensoreinheit einer Digitalkamera ist, erzeugt ein genau definiertes Maß an Unschärfe und unterdrückt so jene feinen Details, die sonst als Moiré digitalisiert würden.Das Tiefpassfilter auf dem Sensor sorgt zwar für Bilder ohne Artefakte, macht dafür aber die Auflösungsleistung des Objektivs teilweise zunichte. Man versucht daher, die Filterung auf das unbedingt nötige Maß zu beschränken, also einen Kompromiss zwischen Auflösung und Artefaktfreiheit zu finden.

Im Mittelformatbereich gehen die Kamerahersteller noch weiter und verzichten meist gänzlich auf ein Tiefpassfilter; Leica hat das Filter auch bei seiner M8 und M9 weggelassen und Olympus seinem FourThirds-Modell E-5 ein bewusst schwach dimensioniertes Tiefpassfilter mitgegeben, um möglichst wenig Auflösung zu verschenken. Die Gefahr des Moiré soll stattdessen die Bildverarbeitung in der Kamera oder im RAW-Konverter bannen. Kann diese Strategie aber überhaupt aufgehen, wenn doch das Abtasttheorem dem störungsfreien Auflösungsvermögen eine nicht zu überschreitende Grenze zu setzen scheint?

Canon verwendet in seinen EOS-Kameras aufwändige Tiefpassfilter, um die Frequenzen zu unterdrücken, die Moiré entstehen lassen.

Illustration: © Michael J. HußmannFilterlos

Es gehört zu den Eigenheiten mathematischer Modelle, die Realität zu vereinfachen. Das Abtasttheorem geht von der unrealistischen Annahme einer punktförmigen Abtastung aus. Wenn bei einer punktförmigen Abtastung Moiré entsteht, dann nicht so sehr deshalb, weil zu wenig Punkte abgetastet würden, sondern weil diese Punkte nicht repräsentativ für die nicht abgetasteten Punkte dazwischen sind. Es ist so, als wollte man das Wahlverhalten in den deutschen Bundesländern erforschen, aber in jedem Land nur einen einzigen Wähler befragen das Ergebnis bliebe weitgehend dem Zufall überlassen. Solche irreführenden Resultate gehen nicht auf die geringe Auflösung hier die Aufteilung in die Bundesländer zurück, sondern auf den nicht repräsentativen Charakter einer punktförmigen Abtastung.

Sensoren tasten aber keineswegs punktförmig ab; ein punktförmiges Pixel würde überhaupt kein Licht registrieren. Sensorpixel mögen klein sein, aber sie haben eine Fläche, selbst wenn sie nur einige Mikrometer im Quadrat misst. Zwar ist nicht die gesamte Fläche lichtempfindlich, aber da die Mikrolinsen fast alles Licht auf dieser Fläche konzentrieren, sind die aus einem Sensorpixel ausgelesenen Werte repräsentativ für dessen Gesamtfläche. Die flächen- statt punktförmige Abtastung ändert nichts daran, dass die Auflösung des Sensors begrenzt ist, und sie kann die Entstehung von Moiré auch nicht gänzlich vermeiden. Die verbleibenden Artefakte sind aber schwach und treten kaum noch störend in Erscheinung. Die Sensorpixel selbst wirken bereits wie ein Tiefpassfilter, auch wenn dieses nicht so stark ist wie ein typisches Tiefpassfilter vor dem Sensor.

Farbmoiré

Welcher Art sind dann aber die farbigen Streifenmuster, die sich in den Bildern von Kameras ohne Tiefpassfilter zeigen können, wenn das klassische Moiré doch gar kein so großes Problem darstellt? Tatsächlich handelt es sich hierbei um Farbmoiré, dessen Ursache eine andere ist. Farbmoiré ist charakteristisch für Sensoren mit Farbfiltern im Bayer-Muster, deren Auflösungsvermögen für Farbveränderungen viel geringer als das für Veränderungen der Helligkeit ist.

Von vier Sensorpixeln sind je zwei für Grün und je eines für Rot beziehungsweise Blau empfindlich, sodass man für ein vollständiges RGB-Pixel vier Sensorpixel benötigt. Das Problem besteht nun darin, dass die Auflösung des Objektivs idealerweise der Pixelzahl des Sensors gerecht wird, derselbe Sensor aber Farben nur mit einem Viertel dieser Auflösung differenzieren kann. Wenn man aus zwei mal zwei benachbarten Sensorpixeln das einzige für Rot empfindliche Pixel als repräsentativ für den Rotanteil aller vier Pixel nimmt, dann macht gerade die hohe Auflösung von Objektiv und Sensor diese Annahme zunichte:

Tatsächlich kann sich schon von einem Pixel zum nächsten der Anteil einer Grundfarbe ändern. Die Interpolation der fehlenden, von den Sensorpixeln nicht erfassten Farbanteile ist daher fehleranfällig und wenn feine, kontrastreiche Strukturen solche Fehler provozieren, entsteht das gefürchtete Farbmoiré. Die Aufgabe des Tiefpassfilters ist es daher, dem Bild eine so dosierte Unschärfe hinzuzufügen, dass die für eine Grundfarbe empfindlichen Pixel doch wieder repräsentative Werte liefern. Damit beugt das Tiefpassfilter zwar dem Farbmoiré vor, reduziert aber ganz unnötig auch die Helligkeitsauflösung. Die Helligkeitsauflösung ist aber für den Schärfeeindruck entscheidend, während wir eine geringere Farbauflösung tolerieren.

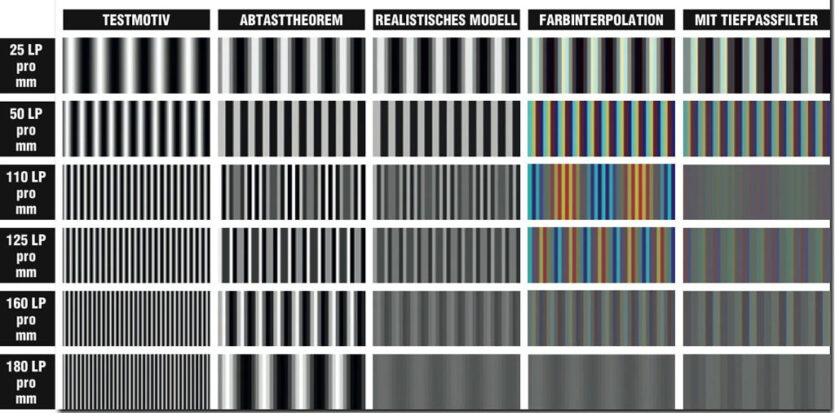

Moirésimulation

Moirésimulation

Der im Bild simulierte Sensor kann bis zu 50 Linienpaare/mm auflösen (linke Spalte: die Ausschnitte entsprechen jeweils 40 x 15 Pixeln); alle noch feineren Details würden durch Moiré verfälscht. Gegenüber dem vom Abtasttheorem vorausgesagten Effekt (zweite Spalte) zeigt ein realistischeres Modell, dass die tatsächlich erzeugten Artefakte schwächer sind (dritte Spalte). Problematischer ist Farbmoiré, das durch Fehler bei der Farbinterpolation entsteht (vierte Spalte; ein die Auflösung begrenzendes Tiefpassfilter hilft, es zu reduzieren.

Moiré vermeiden

Zur Unterdrückung farbiger Artefakte kann man das Bild nach der Farbinterpolation in Farb- und Helligkeitsinformationen auftrennen und die Farbinformationen weichzeichnen. Damit verschwindet zwar das Farbmoiré, aber die Informationen im Helligkeitskanal sind bereits durch die fehlerhafte Interpolation beeinträchtigt und diese Motivdetails lassen sich nicht mehr rekonstruieren. Erfolgversprechender ist es, schon bei der Interpolation der fehlenden Farbinformationen anzusetzen und die Erzeugung von Moiré zu vermeiden, statt es erst im Nachhinein zu unterdrücken. Eine solche Strategie nutzt beispielsweise Hasselblad in seinem RAW-Konverter Phocus. Man macht sich gerade den Umstand zunutze, dass der Sensor eine viel höhere Auflösung für Veränderungen der Helligkeit gegenüber solchen der Farbe hat. Auch ohne zunächst die Farben zu berücksichtigen, kann die Kamera oder ein RAW-Konverter anhand der Sensordaten erkennen, ob es in einzelnen Bildteilen hohe Ortsfrequenzen gibt, die Farbmoiré provozieren würden. Je nachdem kann die Farbinterpolation dann entweder vorsichtig über mehrere Pixel mitteln oder aggressiv die Auflösung optimieren. Da die Helligkeitsinformationen immer auf Basis der vollen Sensorauflösung berechnet werden, bleiben auch feinste Strukturen erhalten; der Verzicht auf ein auflösungsreduzierendes Tiefpassfilter bringt also einen echten Mehrwert. Nur auf eine ebenso feine Auflösung von Farbunterschieden muss man in den kritischen Bildbereichen verzichten; hier zeigen sich dann endgültig die von der Physik vorgegebenen und tatsächlich unüberschreitbaren Grenzen.

Fazit

Moiré entsteht überwiegend aus Fehlern bei der Farbinterpolation von Sensoren mit Bayer-Muster und kann durch ein Tiefpassfilter verringert werden. In einem RAW-Workflow kann man am ehesten auf das schärfereduzierende Tiefpassfilter verzichten; um in der Kamera artefaktfreie JPEG-Bilder zu erzeugen ist es aber derzeit noch unverzichtbar.

Beitrage Teilen