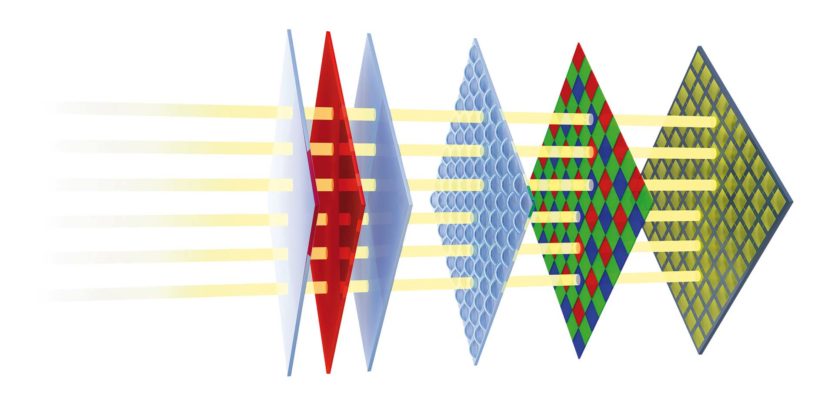

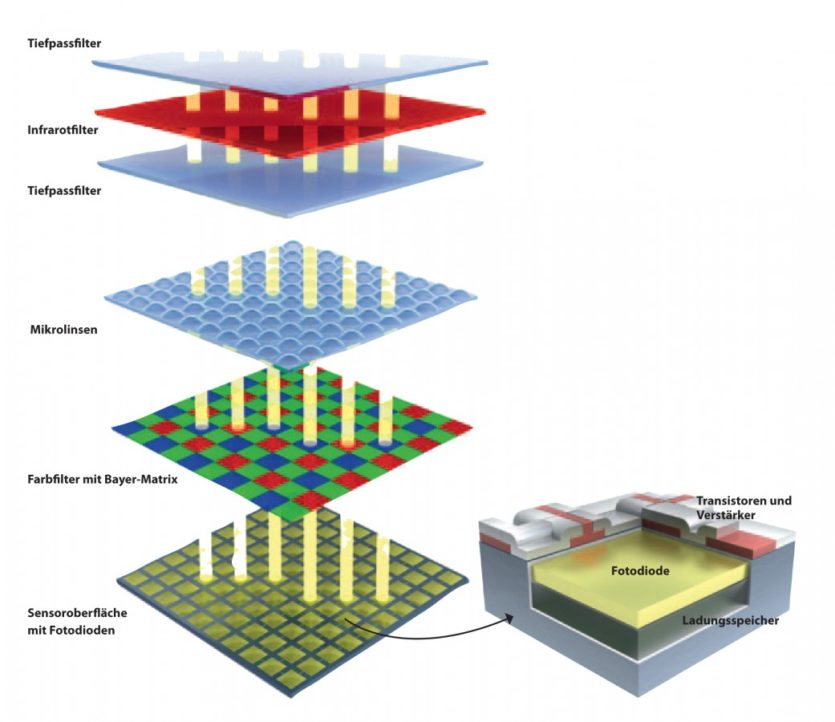

Von links nach rechts: Tiefpassfiter, Infrarotfilter, Tiefpassfilter, Äußere Mikrolinsen, Farbfilter mit Bayer-Matrix, Sensoroberfläche mit Fotodioden.

Illustration: © Christian EisenbergDass sich die Bildqualität einer Digitalkamera nicht in erster Linie an der Anzahl der Pixel ablesen lässt, dürfte sich inzwischen herumgesprochen haben. So nehmen auch die Bildsensoren einen erheblichen Einfluss auf unsere Ergebnisse. Trotzdem verleitet die griffige Pixelzahl immer wieder dazu, sie in den Mittelpunkt zu stellen. Und das, obwohl ein anderer Faktor eine viel größere Rolle bei der Bildqualität und sonstigen Charakteristika eines Kamerasystems spielt – nämlich die Abmessungen des Bildsensors.

Bildsensoren im Überblick

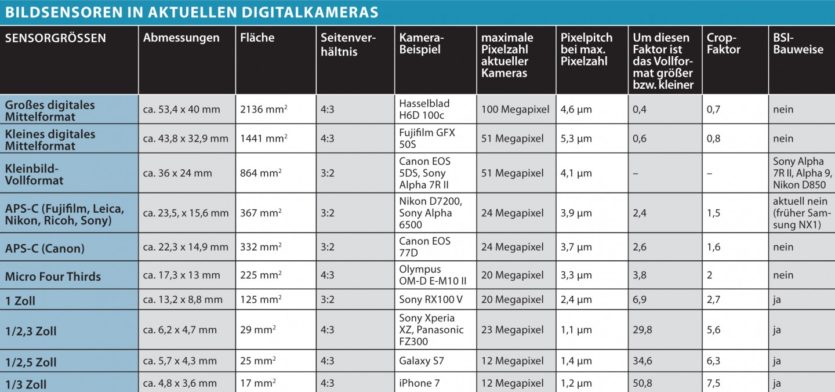

Bildsensoren in aktuellen Digitalkameras

Eine Frage der Größe

Als Oskar Barnack 1913 die erste Kleinbildkamera konstruierte, war der verwendete Film (mit den Negativmaßen 36 x 24 mm) klein – und zwar im Vergleich zu den damals üblichen Aufnahmeformaten wie dem 60 x 90-mm-Rollfilm.

Gut 80 Jahre später kamen die ersten Digitalkameras für eine breite Anwenderschicht auf den Markt. Bildsensoren mit Kleinbild-Abmessungen erschienen zu diesem Zeitpunkt sehr groß und ihre Produktion war schwierig. Durch den hohen Ausschuss waren die kleinbildgroßen Sensoren extrem teuer und kamen zunächst für den Massenmarkt nicht in Frage. Kompaktkameras waren daher von Anfang an mit deutlich kleineren Sensoren ausgestattet. Die winzigen Sensoren haben den bis heute liebgewonnenen Nebeneffekt, dass sich die Objektive kleiner bauen lassen, da sie mit kürzeren Brennweiten auskommen (siehe „Brennweite und Crop-Faktor“, unten).

Erst die digitalen Spiegelreflexkameras (SLRs) brachten wieder größere Sensoren ins Spiel: Mit den ersten SLRs für den Massenmarkt von Canon (2003: EOS 300D) und Nikon (2004: D70) setzten sich die sogenannten APS-C-Sensoren (bei Nikon DX genannt) durch, die um den Faktor 2,3 bis 2,6 kleiner sind als das Kleinbild. Spiegelreflexkameras mit kleinbildgroßen Sensoren waren erst ab 2005 auf breiter Front erfolgreich – das erste Modell für eine größere Käuferschicht war die Canon EOS 5D.

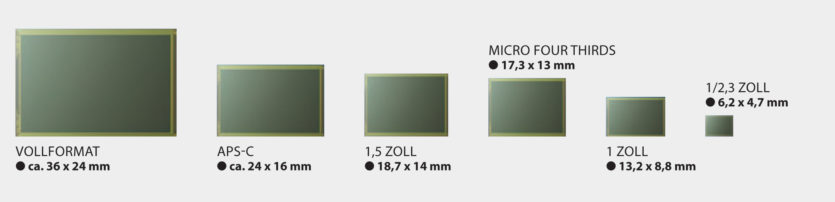

Sensorgrößen im Vergleich

Sensorgrößen im Vergleich: In Digitalkameras kommen Bildsensoren mit sehr unterschiedlichen Größen zum Einsatz. Der Vollformatsensor hat fast die 30fache Fläche des kleinen 1/2,3-Zoll-Typs.

Die Marketingstrategen der Kameraindustrie benannten das Kleinbild geschickt in das besser klingende Vollformat um. Der Begriff ist durchaus problematisch: Er weckt die Illusion, dass es ein „ideales“ Sensorformat gäbe – alles andere ist entweder nicht „voll(ständig)“ oder „übervoll“. Tatsächlich ist jede Sensorgröße und damit jede Kamera ein Kompromiss mit Vor- und Nachteilen.

Je größer der Sensor ist, desto besser könnte – zumindest unter idealen Bedingungen und bei gleichem Entwicklungsstand – die Bildqualität sein. So lässt sich die Auflösung steigern oder durch größere Pixel das Bildrauschen und die Dynamik verbessern. Im Gegenzug werden aber Kameras und Objektive größer und teurer. Wie die digitalen Mittelformatkameras zeigen, ist aber auch das Vollformat bei der Bildqualität schon ein Kompromiss – es geht auch größer und höher auflösend (aktuell bis 100 Megapixel). Oder aber natürlich kleiner, leichter und billiger.

Der Fortschritt bei Bildsensoren führt dazu, dass heute zumindest bis ISO 800 die Unterschiede zwischen dem Vollformat und den kleineren APS-C- und Micro-Four-Thirds-Sensoren nur bei sehr kritischer Betrachtung oder starken Belichtungskorrekturen im Raw-Konverter sichtbar werden. Wie weit die Kompromissbereitschaft geht, muss jeder selber entscheiden. Smartphones und viele Kompaktkameras nutzen Sensoren, die nur noch 1/30tel bis 1/50tel der Fläche des Kleinbilds haben – dafür lassen sich Objektive im ultraflachen Handygehäuse unterbringen oder Kameras mit 40fach-Zooms konstruieren, die in die Hosentasche passen.

Brennweite und Crop-Faktor

Die Brennweite beschreibt den Abstand zwischen der bildseitigen Hauptebene des Objektivs und dem Brennpunkt auf dem Bildsensor bzw. dem Film. Sie wird aber meist mit dem von einem Kamerasystem erfassten Bildwinkel assoziiert. So denken die meisten Fotografen bei einer Brennweite von 28 mm an ein Weitwinkel und bei 100mm an ein leichtes Tele. Dieser Zusammenhang von Brennweite und Bildwinkel ist aber nur bei einer bestimmten Film- bzw. Sensorgröße korrekt, nämlich beim Kleinbild-Film respektive dem gleich großen digitalen „Vollformat“.

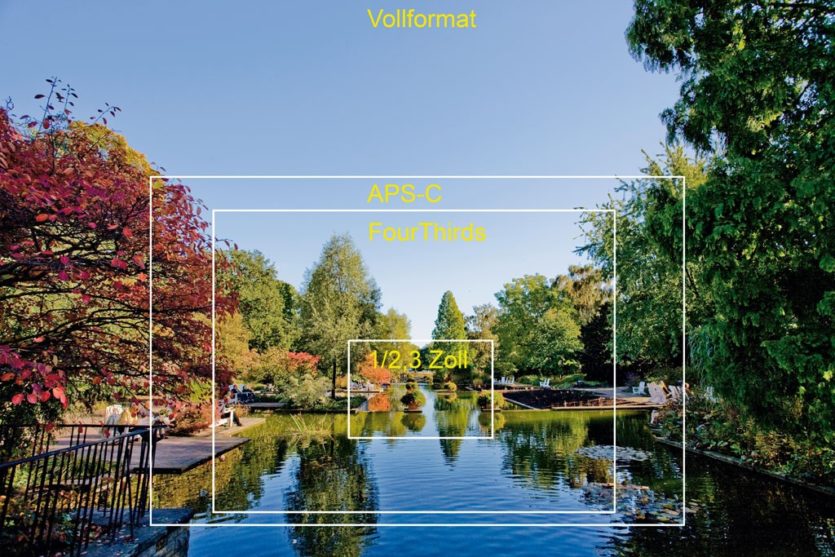

Bildausschnitte in der Übersicht

Kleinere Sensoren bilden einen Ausschnitt ab und simulieren so längere Brennweiten.

Foto: © Andreas JordanWas passiert nun, wenn ein für das Vollformat ausgelegtes 28-mm-Objektiv an einer Kamera mit kleinerem Bildsensor betrieben wird? Der kleinere Sensor erfasst logischerweise einen kleineren Bildausschnitt – das Bild wird beschnitten. Beschnitt heißt auf Englisch Crop, deshalb spricht man auch vom Crop-Faktor (manchmal ist auch vom Format-Faktor die Rede). Die umgangssprachlich benutzte Brennweitenverlängerung ist technisch falsch, denn die Brennweite ändert sich durch kleinere Sensoren nicht.

Der Crop-Faktor gibt an, welche Brennweite am Kleinbild/Vollformat den gleichen Bildwinkel erfassen würde. Er wird auf Basis der Sensordiagonale berechnet. So hat ein APS-C-Sensor von Fujifilm, Nikon, Ricoh oder Sony eine Diagonale, die um den Faktor 1,5 kürzer ist als beim Kleinbild bzw. Vollformat. Ein 28-mm-Objektiv erfasst daher an APS-C-Kameras der besagten Kamerahersteller den gleichen Bildwinkel wir ein 42-mm-Objektiv am Kleinbild/Vollformat. Anders ausgedrückt: Je kleiner der Sensor ist, umso weitwinkliger und kleiner können die Objektive sein, um den gleichen Bildwinkel zu erfassen.

Von der Fotodiode zum Pixel

Unabhängig von der Größe sind alle Bildsensoren ähnlich aufgebaut. Ihre zentralen Bestandteile sind Fotodioden aus Silizium, deren Anzahl der Pixelzahl entspricht. Sie nutzen den „photoelektrischen Effekt“ – für dessen Beschreibung Albert Einstein 1921 den Nobelpreis erhielt –, um Lichtteilchen (Photonen) in elektrische Ladung (Elektronen) zu wandeln.

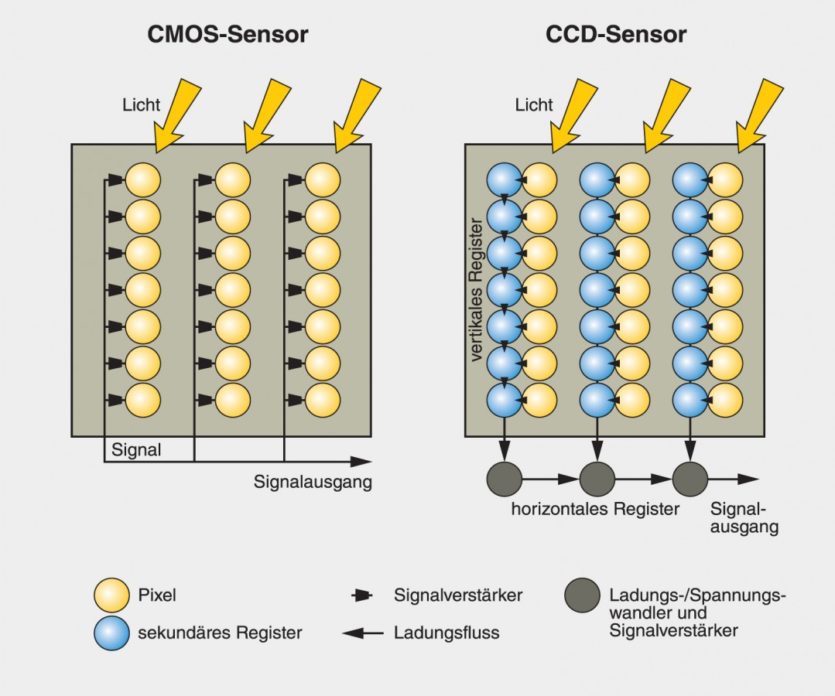

Die ersten Bildsensoren waren nach dem CCD-Prinzip (Charge-coupled Device, ladungsgekoppeltes Bauteil) konstruiert. Die erzeugte Ladung wird dabei nach dem „Eimerkettenprinzip“ in vielen kleinen Schritten über horizontale und vertikale Register weitergeleitet. Der CCD ist an sich noch kein digitaler Sensor. So kamen CCDs bereits vor dem Beginn der Digitalfotografie in Videokameras (zum Beispiel Hi8) zum Einsatz, welche analoge, elektronische Informationen auf Bandkassetten speicherten. In Digitalkameras wurde dann ein zentraler Analog/Digital-Konverter (ADC) integriert, der die Ladung des CCDs digitalisiert.

CMOS versus CCD

CMOS versus CCD: Die heute in den meisten Kameras genutzten CMOS-Sensoren besitzen pro Pixel einen Verstärker und lassen sich schneller auslesen als CCDs. Die Nachteile sind inzwischen weitgehend ausgeglichen.

Illustration: © fotoMAGAZIN, Rainer JahnkeHeute nutzen fast alle Digitalkameras CMOS-Sensoren (Complementary Metal Oxide Semiconductor). Im Gegensatz zu CCDs haben moderne CMOS-Bildwandler pro Fotodiode einen Verstärker, sodass sich die Pixelelemente einzeln ansprechen und schneller auslesen lassen – man spricht daher auch von einem Active Pixel Sensor (APS, nicht zu verwechseln mit dem Bildformat APS). Das schnelle Auslesen ist die Voraussetzung für hochfrequente Serienbilder, hochauflösende Videos oder Multishot-Funktionen, bei denen mehrere Aufnahmen miteinander verrechnet werden, beispielsweise für Schwenkpanoramen oder HDR-Bilder.

Auch lassen sich mehrere Pixel zusammenschalten („Binning“) oder nur Teile des Sensors auslesen. Weitere Vorteile von CMOS-Sensoren sind ein geringerer Stromverbrauch und das Vermeiden von Streifenbildungen bei hellen Lichtquellen („Smearing“) beziehungsweise die Reduzierung von hellen Flecken bei überbelichteten Bildbereichen („Blooming“).

Es gibt aber auch Nachteile. So können bei Verwendung eines elektronischen Verschlusses (also beispielsweise bei der Videoaufzeichnung) Verzerrungen durch den „Rolling Shutter“-Effekt entstehen. Außerdem reduziert die zusätzliche Elektronik die lichtempfindliche Fläche.

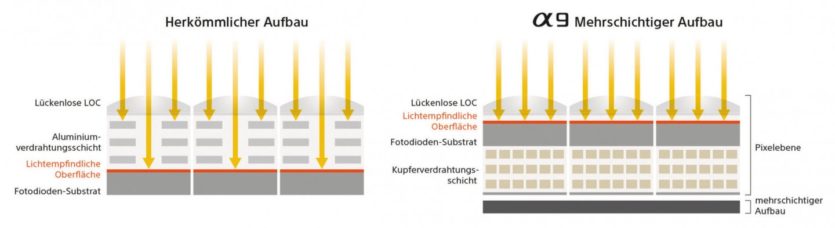

Dieses Problem verringern die Hersteller vor allem bei kleinen CMOS-Sensoren in Kompaktkameras und Smartphones durch die sogenannte BSI-Bauweise (Back-side Illumination). Im Gegensatz zur herkömmlichen Bauweise (auch FSI, Front-side Illumination, genannt) werden die Leiterbahnen dabei hinter die Fotodioden verlegt, um die Lichtausbeute zu erhöhen. Die BSI-Bauweise hat sich bisher weitgehend bei kleinen Sensoren bis 1 Zoll durchgesetzt. Im Micro-Four-Thirds- und APS-C-Bereich gibt es aktuell keine BSI-Sensoren, beim Vollformat hat Sony diese Technologie in der Alpha 7R II sowie Alpha 9 und Nikon in der D850 umgesetzt.

Schichtarbeit

Bevor das Licht auf die Fotodioden trifft und dort in elektrische Ladung gewandelt wird, passiert es noch andere Teile der Sensoreinheit: Ein Infrarot-Sperrfilter verhindert beispielsweise das Auftreten von Falschfarben. Viele Kameras sind außerdem mit einem optischen Tiefpassfilter ausgestattet, das hohe Frequenzen dämpft, vor allem um die Gefahr des Auftretens von Moiré-Artefakten zu verringern. Diese entstehen, wenn es zu Interferenzen zwischen dem Pixelraster des Sensors und Mustern im Bild kommt, beispielsweise bei feinen Strukturen von Textilien oder in der Architektur.

Aufbau eines Bildsensors

Aufbau eines Bildsensors: Zum Aufbau vieler Bildsensoren gehören Tiefpassfilter, Infrarotfilter, Mikrolinsen und RGB-Farbfilter mit Bayer-Matrix. Die Tiefpassfilter werden allerdings in immer mehr Kameras weggelassen, um eine bessere Auflösung zu erreichen. Die höherwertigen Kameras von Fujifilm nutzen statt der 2×2-Bayer-Matrix ein 6×6-Raster (siehe unten)

Aufbau eines CMOS-Pixels: CMOS-Sensoren besitzen pro Pixel einen Verstärker

Foto: © fotoMAGAZIN/Christian EisenbergImmer mehr Hersteller lassen das Tiefpassfilter allerdings inzwischen weg, um die maximale Auflösung aus dem Sensor herauszuholen. Dafür spricht auch, dass angesichts der hohen Pixeldichte aktueller Sensoren Moirés nur noch bei sehr feinen Strukturen sichtbar werden, die seltener vorkommen und unter Umständen schon vom Objektiv nicht mehr aufgelöst werden – Moirés treten eher bei besonders hochwertigen Objektiven auf, die im optimalen Leistungsbereich betrieben werden. Darüber hinaus können Moirés auch softwareseitig reduziert werden – bei JPEGs in der Kamera, bei Raws im Konverter am PC.

Zwischen Infrarot- und Tiefpassfilter befinden sich zwei weitere Elemente des Sensors: Die Mikrolinsen haben die Aufgabe, das Licht so zu bündeln, dass es möglichst präzise auf die Fotodioden fällt. Außerdem befindet sich bei Farbsensoren direkt über den Fotodioden eine mosaikartige RGB-Filtermatrix (nach dem Kodak-Ingenieur Bryce E. Bayer auch Bayer-Matrix genannt). Sie sorgt dafür, dass pro Pixel jeweils eine Grundfarbe des additiven Farbmodells erfasst wird, also Rot, Grün oder Blau. Die Mischfarben der einzelnen Pixel werden dann nach der Aufnahme aus den Nachbarpixeln berechnet – man spricht von Farbinterpolation oder „Demosaicing“.

Leica und Hasselblad integrieren in einige Kameras auch reine Schwarzweiß-Sensoren, bei denen die Farbfilter weggelassen werden. Dies hat den Vorteil, dass die Empfindlichkeit des Sensors steigt, da die Farbfilter Licht schlucken. Die Aufnahmen werden außerdem etwas schärfer, weil die Farbinterpolation entfällt und kein Tiefpassfilter zum Einsatz kommt.

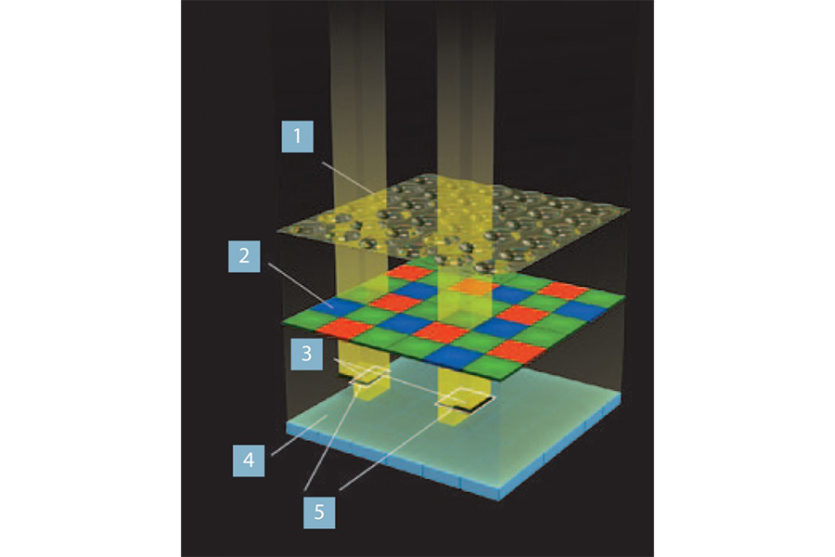

Die X-Trans-Sensoren von Fujifilm nutzen eine andere Farbmatrix als herkömmliche Sensoren. Auf dem Sensor sind Autofokus-Pixel mit Phasendetektion integriert

1 Mikrolinsen

2 X-Trans-Farbfilter

3 L/R-Lichtfiltermaske

4 Fotodioden

5 Phasendetektionspixel

Sensorgröße, Schärfentiefe und kleinbildäquivalente Blende

Die Schärfentiefe beschreibt die Ausdehnung des Schärfebereichs vor und hinter dem Motiv, auf das fokussiert wird. Sie ist im Wesentlichen von zwei Faktoren abhängig: Dem Abbildungsmaßstab und der Größe der Blendenöffnung. Es gilt: Je größer der Abbildungsmaßstab und je größer die Blendenöffnung, umso geringer ist die Schärfentiefe.

Daraus ergibt sich, dass größere Sensoren eine geringe Schärfentiefe zur Folge haben. Wenn Sie beispielsweise ein Oberkörperportrait aufnehmen, so ist bei identischem Bildausschnitt das Abbild auf einem Vollformatsensor deutlich größer als auf einem 1-Zoll-Sensor – sprich der Abbildungsmaßstab ist beim Vollformat größer und damit die Schärfentiefe bei gleicher Blende geringer.

In Kombination mit einem einigermaßen lichtstarken Objektiv entstehen so mit Vollformatkameras „professionell“ wirkende Aufnahmen, bei denen sich das Portrait angenehm vom unscharfen Hintergrund abhebt. Um den gleichen Effekt mit einem kleineren Sensor zu erzielen, benötigen Sie ein lichtstärkeres Objektiv mit einer größeren relativen Blendenöffnung.

Eine geringe Schärfentiefe ist auch mit kleinen Sensoren (hier 1/1,8 Zoll) möglich, wenn es sich um Nahaufnahmen kleiner Motive handelt.

Foto: © Andreas JordanDie Umrechnung erfolgt wie bei der Brennweite über den Crop-Faktor (man spricht auch von einer kleinbildäquivalenten Blende). Um den gleichen Effekt wie mit Blende f/2,8 am Vollformat zu erzielen, benötigen Sie an einer APS-C-Kamera Blende f/1,8 und an einer Micro-Four-Thirds-Kamera Blende f/1,4. Schon beim 1-Zoll-Sensor bräuchte man ein in der Praxis nicht verfügbares Objektiv mit Blende f/1, bei noch kleineren Sensoren landet man bei utopischen f/0,5 oder größer.

Zukunftsaussichten

Eine relativ neue Entwicklung stellen sogenannte Stacked-CMOS-Sensoren dar. Dabei wird schneller DRAM-Speicher in die Sensoren integriert, was die Auslesegeschwindigkeit erhöht. Als erstes hielt diese Technologie Einzug in die kleinen Smartphone-Sensoren.

Erklärt: der Exmor-RS-Sensor von Sony

Der Exmor-RS-Sensor in der Sony Alpha 9 (rechts) kombiniert eine BSI-Bauweise für eine optimierte Lichtausbeute mit integriertem DRAM und Kupferverdrahtung für eine höhere Geschwindigkeit. Die Mikrolinsen sind lückenlos angeordnet.

Foto: © SonySony hat sie 2015 erstmals in Kompaktkameras mit 1-Zoll-Sensoren (RX100 IV und RX10 II) und vor kurzem in die Vollformatkamera Alpha 9 integriert. Das schnelle Auslesen ermöglicht in der Alpha 9 Serienaufnahmen mit 20 Bildern/s oder 5fach-Zeitlupen mit 120 Bilder/s in Full-HD. Für Smartphones hat Sony sogar einen Stacked-CMOS-Sensor angekündigt, der Superzeitlupen mit 1000 Bildern/s in Full-HD schafft.

Mehr oder weniger große Modifikationen der herkömmlichen Sensoren haben Fujifilm und Sigma vorgenommen. Fuji hat für seine X-Trans-Sensoren eine eigene Farbfiltermatrix entwickelt, die zwar auch Rot, Grün und Blau verwendet, diese Farben aber in einem größeren Raster (6 x 6 statt 2 x 2) anordnet, was Moirés reduzieren soll. X-Trans-Sensoren kommen daher grundsätzlich ohne Tiefpassfilter aus.

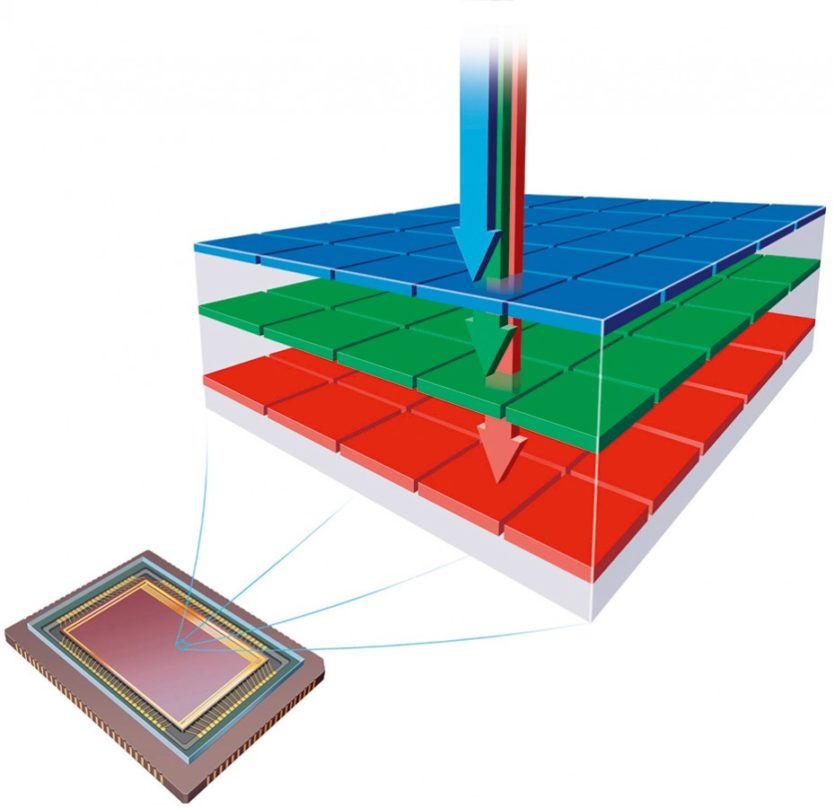

Ebenfalls auf das Tiefpassfilter verzichten die Foveon-Direktbildsensoren von Sigma. Sie sind in drei RGB-Farbschichten aufgebaut, sodass die Farbe nicht aus nebeneinander liegenden Pixeln interpoliert werden muss, sondern pro Flächenpixel die volle RGB-Information zur Verfügung steht. Im Test erreichen die Sigma-Sensoren extrem hohe Auflösungen, rauschen aber deutlich stärker als Bildwandler mit Bayer-Matrix.

Bei den Foveon-Direktbildsensoren von Sigma werden die Farben nicht über nebeneinanderliegende Pixel ermittelt, sondern mit Hilfe übereinanderliegender Farbschichten.

Foto: © SigmaAktuell werden herkömmliche Bildsensoren eher langsam weiterentwickelt, es existieren aber auch Ansätze, die größere Fortschritte versprechen. Das kalifornische Unternehmen InVisage hat beispielsweise schon 2010 die Entwicklung eines QuantumFilm-Sensors angekündigt. Statt herkömmlicher Fotodioden nutzt er Nanopartikel mit Halbleitereigenschaften, die als Filmschicht auf den Sensor aufgetragen werden und die gesamte Sensoroberfläche lichtempfindlich machen.

Einsatzbereich sollen unter anderem Smartphones und Videokameras sein, bisher ist uns aber kein Produkt bekannt, das den InVisage-Sensor einsetzt. Einen ähnlichen Ansatz verfolgt der organische Sensor, dessen Entwicklung Fujifilm und Panasonic 2013 angekündigt hatten – auch er hat es noch nicht zur Marktreife gebracht.

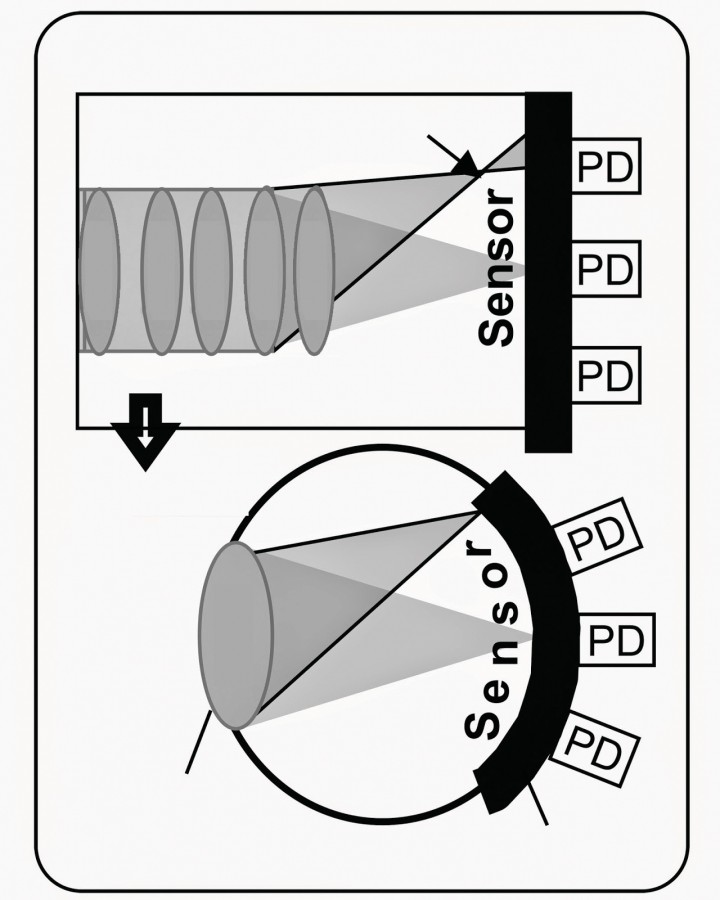

Ebenfalls seit längerem in der Diskussion sind gekrümmte Sensoren. Sie sollen die Bildfeldwölbung eines Objektives durch eine konkave Krümmung der Sensorfläche ausgleichen und so eine bessere Auflösung, vor allem am Bildrand, erreichen – und das bei einfachen und kompakten Objektivkonstruktionen.

Sony-Patent für einen gekrümmten Sensor. Das Objektiv kann einfacher konstruiert werden und trotzdem ist die Abbildungsqualität vor allem am Bildrand besser.

Foto: © SonyDen ersten bekannten Prototypen eines Sensors hat Sony entwickelt – Bildbeispiele wurden schon 2014 veröffentlicht. Vor kurzem hat das französische Unternehmen CEA-LETI einen ähnlichen Sensor mit annähernd Vollformatabmessungen (32 x 24 mm) vorgestellt, der in Teleskopen zum Einsatz kommen soll. Auch Microsoft arbeitet im Rahmen des Projekts Vermont an einer entsprechenden Technologie und diverse Hersteller haben Patente für gekrümmte Sensoren (beispielsweise Apple und Canon) bzw. dazu passende Objektive (Nikon).

Das Hauptproblem scheint zurzeit darin zu bestehen, dass der Sensor nur für die Bildfeldwölbung einer konkreten Festbrennweite korrigiert werden kann und somit schlecht für Zooms und Wechselobjektive geeignet ist. Er dürfte also zunächst in Smartphones oder Kompaktkameras Einzug halten.

_______________________

Dieser Artikel ist in unserer Ausgabe fotoMAGAZIN 10/2017 erschienen.

Beitrage Teilen